Naukowcy z Uniwersytetu w Minnesocie wprowadzili innowację sprzętową o nazwie CRAM, która pozwala zmniejszyć zużycie energii sztucznej inteligencji nawet 2500 razy poprzez przetwarzanie danych w pamięci, co stanowi obietnicę znacznego postępu w wydajności sztucznej inteligencji.

To urządzenie może zmniejszyć zużycie energii przez sztuczną inteligencję co najmniej 1000 razy.

Naukowcy zajmujący się inżynierią na Uniwersytecie Minnesota Twin Cities opracowali zaawansowane urządzenie sprzętowe, które może zmniejszyć zużycie energii sztuczna inteligencja (AI) aplikacje obliczeniowe co najmniej 1000 razy.

Badanie zostało opublikowane w npj Niekonwencjonalne obliczenia, recenzowane czasopismo naukowe publikowane przez Nature. Naukowcy posiadają wiele patentów na technologię zastosowaną w urządzeniu.

Wraz z rosnącym zapotrzebowaniem na aplikacje AI badacze szukają sposobów stworzenia bardziej energooszczędnego procesu, przy jednoczesnym utrzymaniu wysokiej wydajności i niskich kosztów. Zwykle procesy maszynowe lub sztucznej inteligencji przesyłają dane między logiką (gdzie informacje są przetwarzane w systemie) a pamięcią (gdzie przechowywane są dane), zużywając dużą ilość mocy i energii.

Wprowadzenie technologii CRAM

Zespół naukowców z College of Science and Engineering na Uniwersytecie Minnesota zademonstrował nowy model, w którym dane nigdy nie opuszczają pamięci, zwany obliczeniową pamięcią o dostępie swobodnym (CRAM).

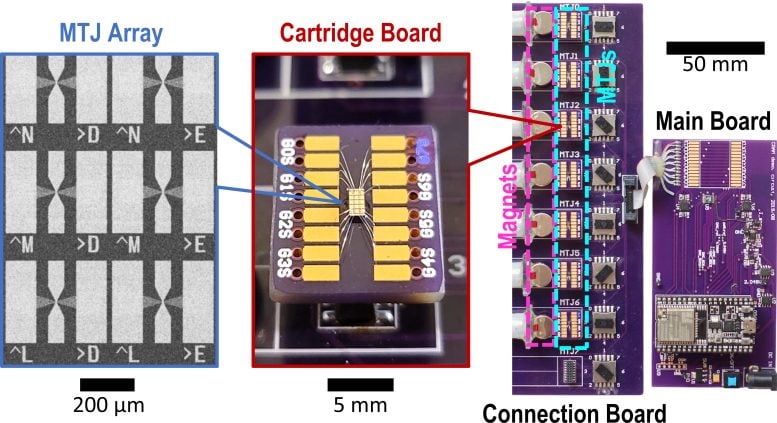

„Ta praca to pierwsza eksperymentalna demonstracja CRAM, w której dane mogą być przetwarzane całkowicie w macierzy pamięci bez konieczności opuszczania siatki, w której komputer przechowuje informacje” – powiedział Yang Lv, Wydział Inżynierii Elektrycznej i Komputerowej Uniwersytetu Minnesota doktor habilitowany i pierwszy autor pracy.

Zaprojektowane na zamówienie urządzenie sprzętowe ma pomóc sztucznej inteligencji zwiększyć efektywność energetyczną. Źródło: Miasta Bliźniacze Uniwersytetu Minnesota

Międzynarodowa Agencja Energetyczna (IEA) wydała prognoza globalnego zużycia energii w marcu 2024 r., prognozując, że zużycie energii na potrzeby sztucznej inteligencji prawdopodobnie podwoi się z 460 terawatogodzin (TWh) w 2022 r. do 1000 TWh w 2026 r. Odpowiada to mniej więcej zużyciu energii elektrycznej w całej Japonii.

Według autorów nowego artykułu, oparty na technologii CRAM nauczanie maszynowe Szacuje się, że akcelerator wnioskowania osiągnie poprawę rzędu 1000. Inny przykład wykazał oszczędność energii od 2500 do 1700 razy w porównaniu z metodami tradycyjnymi.

Ewolucja badań

Badania te trwały ponad dwie dekady,

„Nasz początkowy pomysł wykorzystania komórek pamięci bezpośrednio do obliczeń 20 lat temu uznano za szalony” – powiedział Jian-Ping Wang, starszy autor artykułu i wybitny profesor McKnight oraz kierownik katedry Roberta F. Hartmanna na Wydziale Inżynierii Elektrycznej i Komputerowej na Uniwersytecie w Minnesocie.

„Dzięki rozwijającej się od 2003 roku grupie studentów i prawdziwie interdyscyplinarnemu zespołowi wykładowców zbudowanemu na Uniwersytecie Minnesota – od fizyki, inżynierii i inżynierii materiałowej, informatyki i inżynierii, po modelowanie i benchmarking oraz tworzenie sprzętu – udało nam się uzyskać pozytywne wyniki i obecnie wykazały, że tego rodzaju technologia jest wykonalna i gotowa do wykorzystania w technologii” – powiedział Wang.

Badania te stanowią część spójnych i długotrwałych wysiłków opierających się na przełomowych, opatentowanych badaniach Wanga i jego współpracowników nad urządzeniami Magnetic Tunnel Junctions (MTJ), które są urządzeniami nanostrukturalnymi używanymi do ulepszania dysków twardych, czujników i innych systemów mikroelektroniki, w tym Magnetyczna pamięć o dostępie swobodnym (MRAM), która jest stosowana w systemach wbudowanych, takich jak mikrokontrolery i smartwatche.

Architektura CRAM umożliwia prawdziwe obliczenia w pamięci i poprzez pamięć oraz burzy ścianę pomiędzy obliczeniami a pamięcią, stanowiącą wąskie gardło w tradycyjnej architekturze von Neumanna, teoretycznym projekcie komputera z zapisanym programem, który służy jako podstawa dla prawie wszystkich współczesnych komputerów.

„Jako niezwykle energooszczędny, cyfrowy substrat obliczeniowy w pamięci, CRAM jest bardzo elastyczny, ponieważ obliczenia można wykonywać w dowolnym miejscu macierzy pamięci. W związku z tym możemy rekonfigurować CRAM tak, aby jak najlepiej odpowiadał potrzebom wydajnościowym różnorodnego zestawu algorytmów sztucznej inteligencji” – powiedziała Ulya Karpuzcu, ekspert w dziedzinie architektury obliczeniowej, współautorka artykułu i profesor nadzwyczajny na Wydziale Inżynierii Elektrycznej i Komputerowej Uniwersytetu Wrocławskiego. uniwersytet w Minnesocie. „Jest bardziej energooszczędny niż tradycyjne elementy składowe dzisiejszych systemów sztucznej inteligencji”.

CRAM wykonuje obliczenia bezpośrednio w komórkach pamięci, efektywnie wykorzystując strukturę tablicową, co eliminuje potrzebę powolnego i energochłonnego przesyłania danych, wyjaśnił Karpuzcu.

Najbardziej wydajne krótkoterminowe urządzenie pamięci o dostępie swobodnym, czyli RAM, wykorzystuje cztery lub pięć tranzystorów do kodowania jedynki lub zera przed jednym MTJ, urządzenie spintroniczne, może wykonywać tę samą funkcję przy ułamku energii i z większą szybkością, i jest odporny na trudne warunki. Urządzenia spintroniczne do przechowywania danych wykorzystują spin elektronów, a nie ładunek elektryczny, co stanowi wydajniejszą alternatywę dla tradycyjnych chipów tranzystorowych.

Obecnie zespół planuje nawiązać współpracę z liderami branży półprzewodników, w tym z Minnesotą, w celu zapewnienia demonstracji na dużą skalę i wyprodukowania sprzętu umożliwiającego udoskonalenie funkcjonalności sztucznej inteligencji.

Odniesienie: „Eksperymentalna demonstracja obliczeniowej pamięci o dostępie swobodnym opartej na złączach tunelu magnetycznego” autorstwa Yang Lv, Brandon R. Zink, Robert P. Bloom, Hüsrev Cılasun, Pravin Khanal, Salonik Resch, Zamshed Chowdhury, Ali Habiboglu, Weigang Wang, Sachin S. Sapatnekar, Ulya Karpuzcu i Jian-Ping Wang, 25 lipca 2024 r., npj Niekonwencjonalne obliczenia.

DOI: 10.1038/s44335-024-00003-3

Oprócz Lv, Wanga i Karpuzcu w skład zespołu weszli badacze z Wydziału Inżynierii Elektrycznej i Komputerowej Uniwersytetu Minnesota, Robert Bloom i Husrev Cilasun; Wybitny profesor McKnight oraz przewodniczący Robert i Marjorie Henle Sachin Sapatnekar; oraz byli badacze ze stopniem doktora Brandon Zink, Zamshed Chowdhury i Salonik Resch; wraz z badaczami z Uniwersytetu w Arizonie: Pravinem Khanalem, Alim Habiboglu i profesorem Weigangiem Wangiem

Prace te zostały wsparte grantami amerykańskiej Agencji Zaawansowanych Projektów Badawczych w dziedzinie Obrony (DARPA), Narodowy Instytut Standardów i Technologii (NIST), Narodowa Fundacja Nauki (NSF) i Cisco Inc. Badania, w tym tworzenie wzorców nanourządzeń, przeprowadzono we współpracy z Minnesota Nano Center, a prace symulacyjne/obliczeniowe wykonano z Minnesota Supercomputing Institute na Uniwersytecie w Minnesocie.