Meta właśnie ogłosiła swój własny model sztucznej inteligencji zorientowany na media, nazwany Movie Gen, którego można używać do generowania realistycznych wideo i klipów audio.

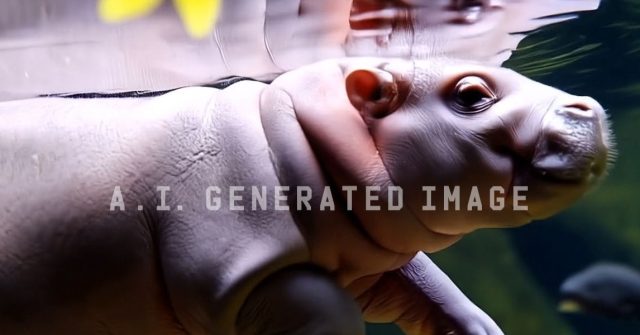

Firma udostępniła wiele 10-sekundowych klipów wygenerowanych za pomocą Film genw tym pływający mały hipopotam w stylu Moo Denga, aby zademonstrować swoje możliwości. Chociaż narzędzie nie jest jeszcze dostępne do użytku, ogłoszenie Movie Gen pojawia się wkrótce po wydarzeniu Meta Connect, podczas którego zaprezentowano nowy i odświeżony sprzęt oraz najnowszą wersję jego dużego modelu językowego, Llama 3.2.

Wykraczając poza generowanie prostych klipów tekstowych na wideo, model Movie Gen może dokonywać ukierunkowanych edycji istniejącego klipu, na przykład dodając obiekt do czyichś rąk lub zmieniając wygląd powierzchni. W jednym z przykładowych filmów Meta kobieta nosząca zestaw VR została przekształcona tak, aby wyglądała, jakby nosiła steampunkową lornetkę.

Urywki audio można generować razem z filmami za pomocą Movie Gen. W przykładowych klipach człowiek AI stoi w pobliżu wodospadu ze słyszalnymi pluskami i pełnymi nadziei dźwiękami symfonii; silnik sportowego samochodu mruczy i piszczy opony, gdy mknie po torze, a wąż ślizga się po dżungli przy akompaniamencie pełnych napięcia klaksonów.

Meta podzieliła się dalszymi szczegółami na temat Movie Gen w artykule badawczym opublikowanym w piątek. Movie Gen Video składa się z 30 miliardów parametrów, natomiast Movie Gen Audio składa się z 13 miliardów parametrów. (Liczba parametrów modelu w przybliżeniu odpowiada jego możliwościom; dla porównania, największy wariant Lamy 3.1 ma 405 miliardów parametrów.) Movie Gen może tworzyć filmy w wysokiej rozdzielczości o długości do 16 sekund, a Meta twierdzi, że przewyższa konkurencyjne modele w ogólnej jakości wideo.

Na początku tego roku dyrektor generalny Mark Zuckerberg zademonstrował funkcję „Imagine Me” Meta AI, dzięki której użytkownicy mogą przesyłać swoje zdjęcia i odgrywać role w różnych scenariuszach, publikując swój obraz AI tonąc w złotych łańcuchach na Wątkach. Wersja wideo podobnej funkcji jest możliwa w przypadku modelu Movie Gen — pomyśl o tym jak o czymś w rodzaju ElfYourself na sterydach.

Na jakich informacjach przeszkolono Movie Gen? Szczegóły nie są jasne w poście informacyjnym Meta: „Wyszkoliliśmy te modele na kombinacji licencjonowanych i publicznie dostępnych zbiorów danych”. Źródła danych szkoleniowych i to, co można pobrać z Internetu, pozostają kwestią sporną w przypadku narzędzi generatywnej sztucznej inteligencji i rzadko kiedy publicznie wiadomo, jaki tekst, wideo lub klipy audio wykorzystano do stworzenia któregokolwiek z głównych modeli.

Ciekawie będzie zobaczyć, ile czasu zajmie Meta udostępnienie Movie Gen. Blog ogłaszający niejasno wskazuje na „potencjalną przyszłą wersję”. Dla porównania OpenAI ogłosiło na początku tego roku swój model wideo AI o nazwie Sora i nie udostępniło go jeszcze publicznie ani nie udostępniło żadnej nadchodzącej daty premiery (chociaż WIRED otrzymał od firmy kilka ekskluzywnych klipów Sora w celu zbadania stronniczości ).

Biorąc pod uwagę dziedzictwo Meta jako firmy zajmującej się mediami społecznościowymi, możliwe jest, że narzędzia oparte na Movie Gen zaczną w końcu pojawiać się na Facebooku, Instagramie i WhatsApp. We wrześniu konkurencyjny Google podzielił się planami udostępnienia twórcom elementów swojego modelu wideo Veo w YouTube Shorts w przyszłym roku.

Podczas gdy większe firmy technologiczne wciąż wstrzymują się z pełnym udostępnieniem modeli wideo publicznie, możesz już teraz eksperymentować z narzędziami wideo AI oferowanymi przez mniejsze, wschodzące start-upy, takie jak Pas startowy I Pika. Jeśli kiedykolwiek zastanawiałeś się, jak by to było zobaczyć siebie, wypróbuj Pikaffects kreskówkowo zmiażdżony za pomocą prasy hydraulicznej lub nagle roztopić się w kałuży.